一、部署环境

操作系统:Windows 10

python:3.10

Langchain-Chatchat v0.3.1

二、部署过程

搭建 conda 虚拟环境

下载 conda

https://www.anaconda.com/download

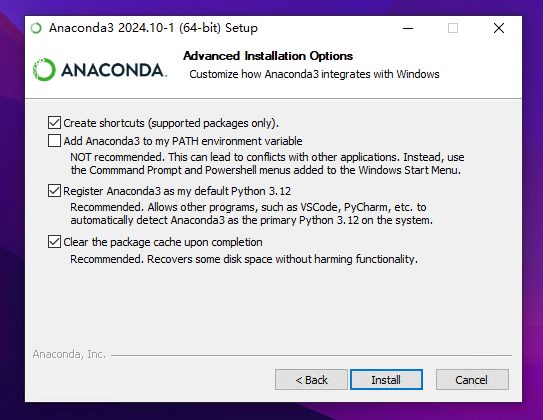

安装 conda

下载安装时建议以管理员身份运行

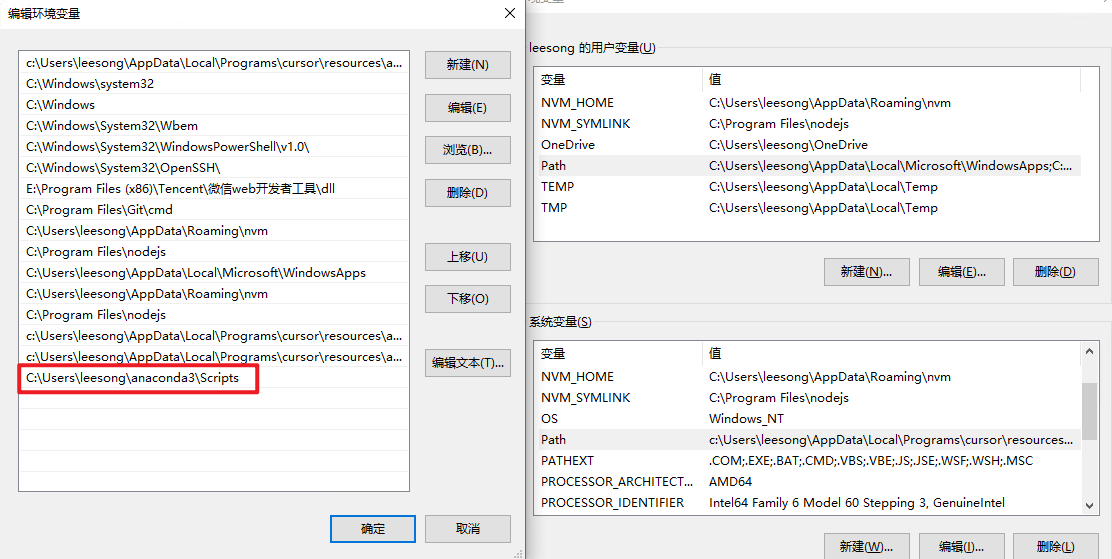

配置 PATH

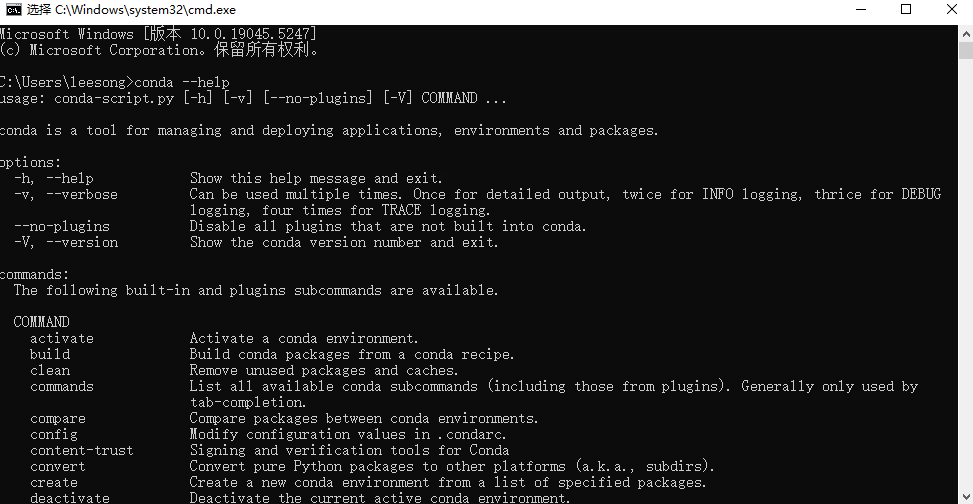

测试 conda

打开 cmd ,输入:conda --help

安装配置成功

创建虚拟环境

chatchat 支持 python 3.8 -> 3.11,这里创建一个 3.10 环境

conda create -n chatchat python=3.10常用 conda 命令

# 激活环境

conda activate

# 退出环境

conda deactivate

# 列出所有环境

conda env list

# 删除环境

conda env remove -n 环境名配置 ollama 环境

下载安装 ollama

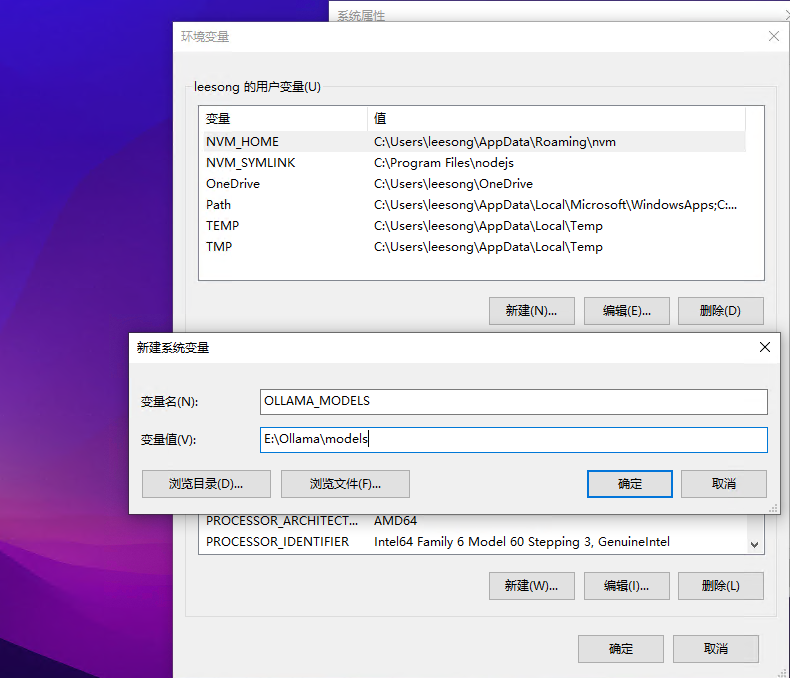

修改模型存储位置

新建一个系统变量,用于存储 Ollama 模型位置

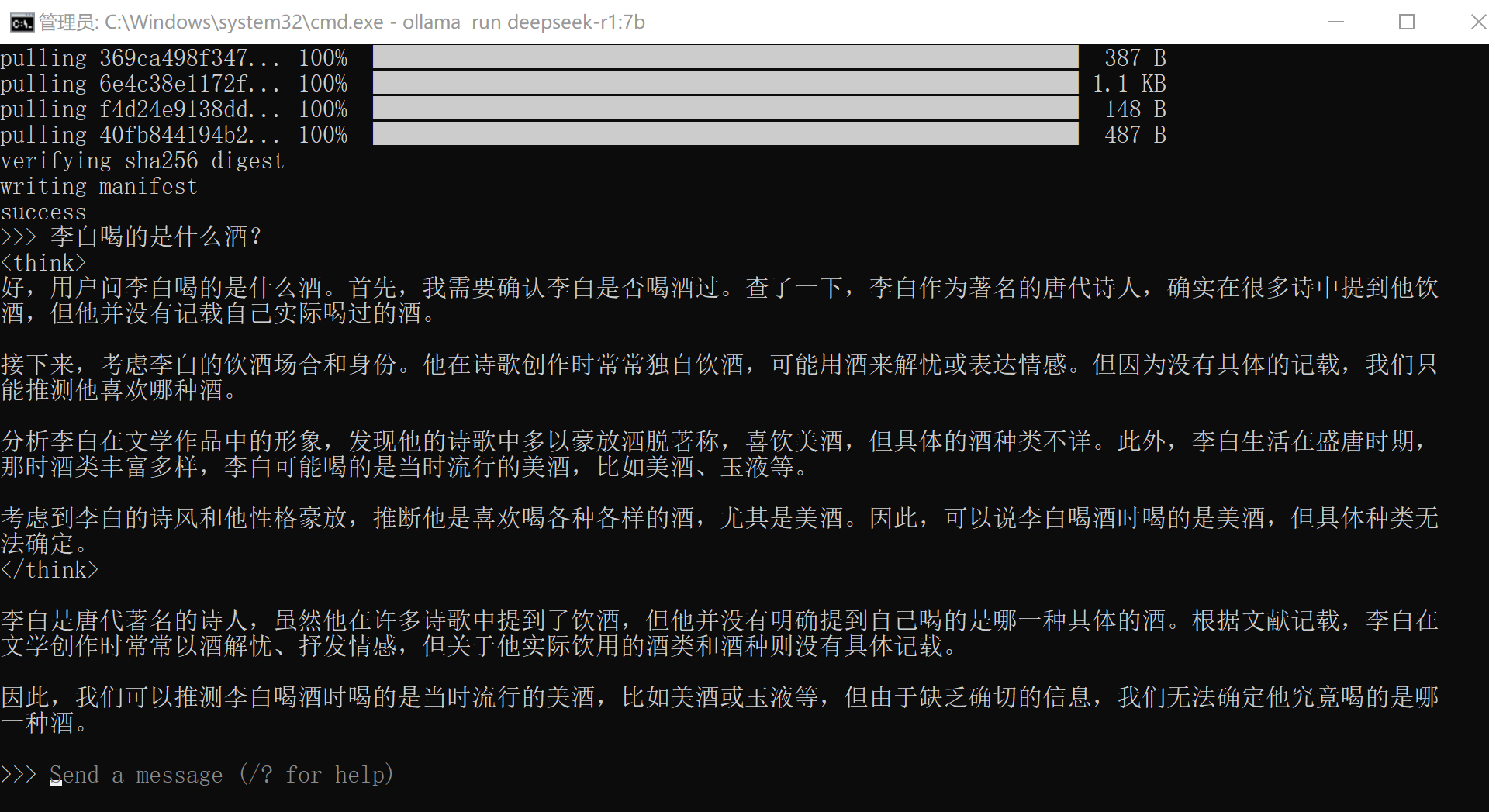

下载模型

下载 deepseek-r1 7b

https://ollama.com/library/deepseek-r1:7b

ollama run deepseek-r1:7b

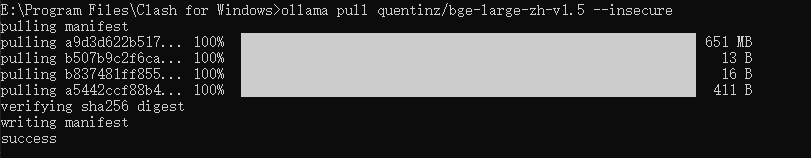

下载一个向量模型

https://ollama.com/quentinz/bge-large-zh-v1.5

ollama pull quentinz/bge-large-zh-v1.5

搭建 chatchat 环境

https://github.com/chatchat-space/Langchain-Chatchat

在 chatchat 的虚拟环境中,安装 chatchat

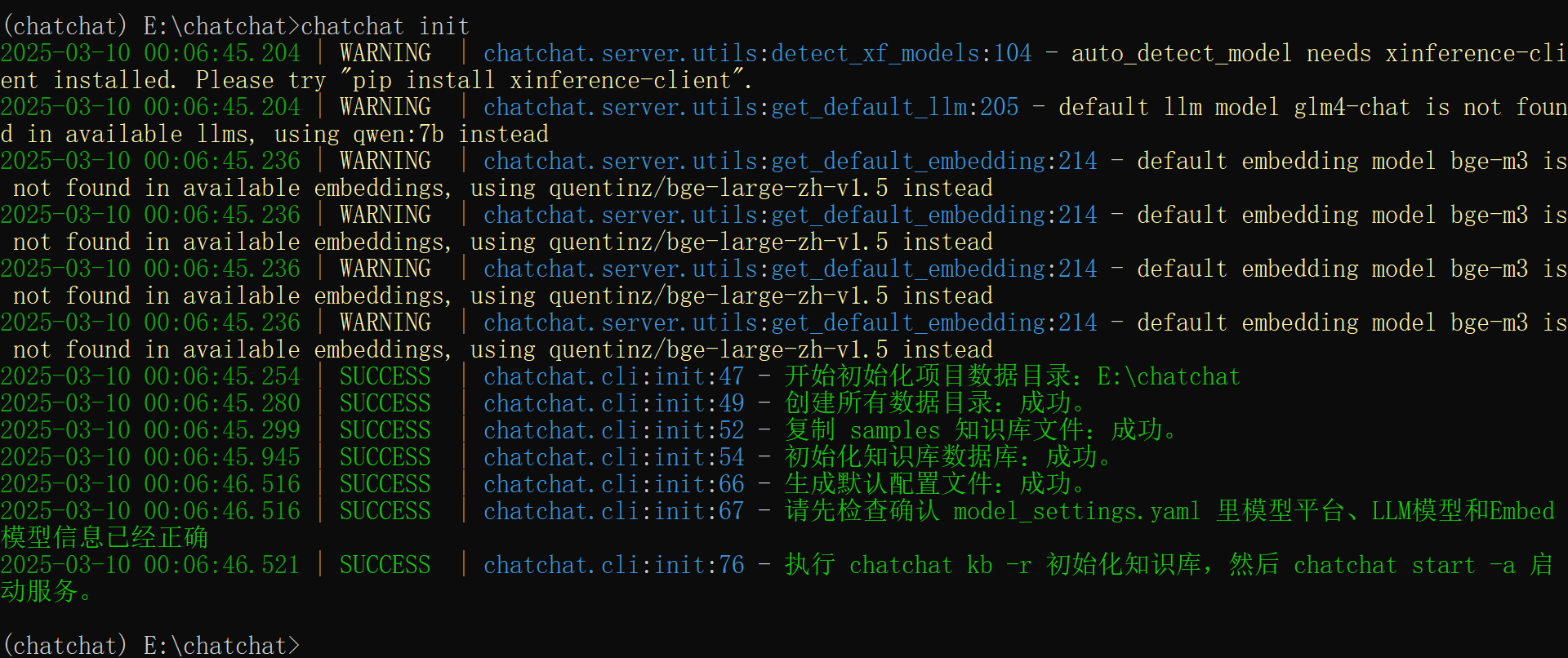

pip install langchain-chatchat -U新建一个目录,进行 chatchat 项目初始化

chatchat init

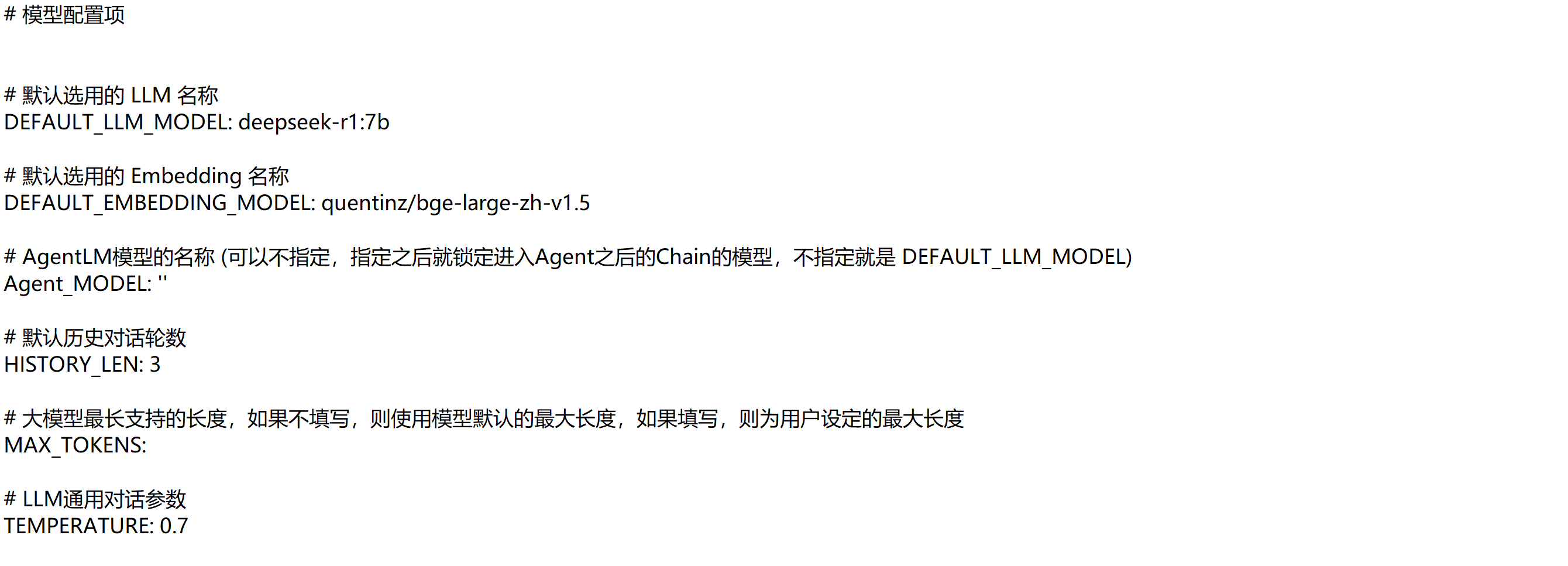

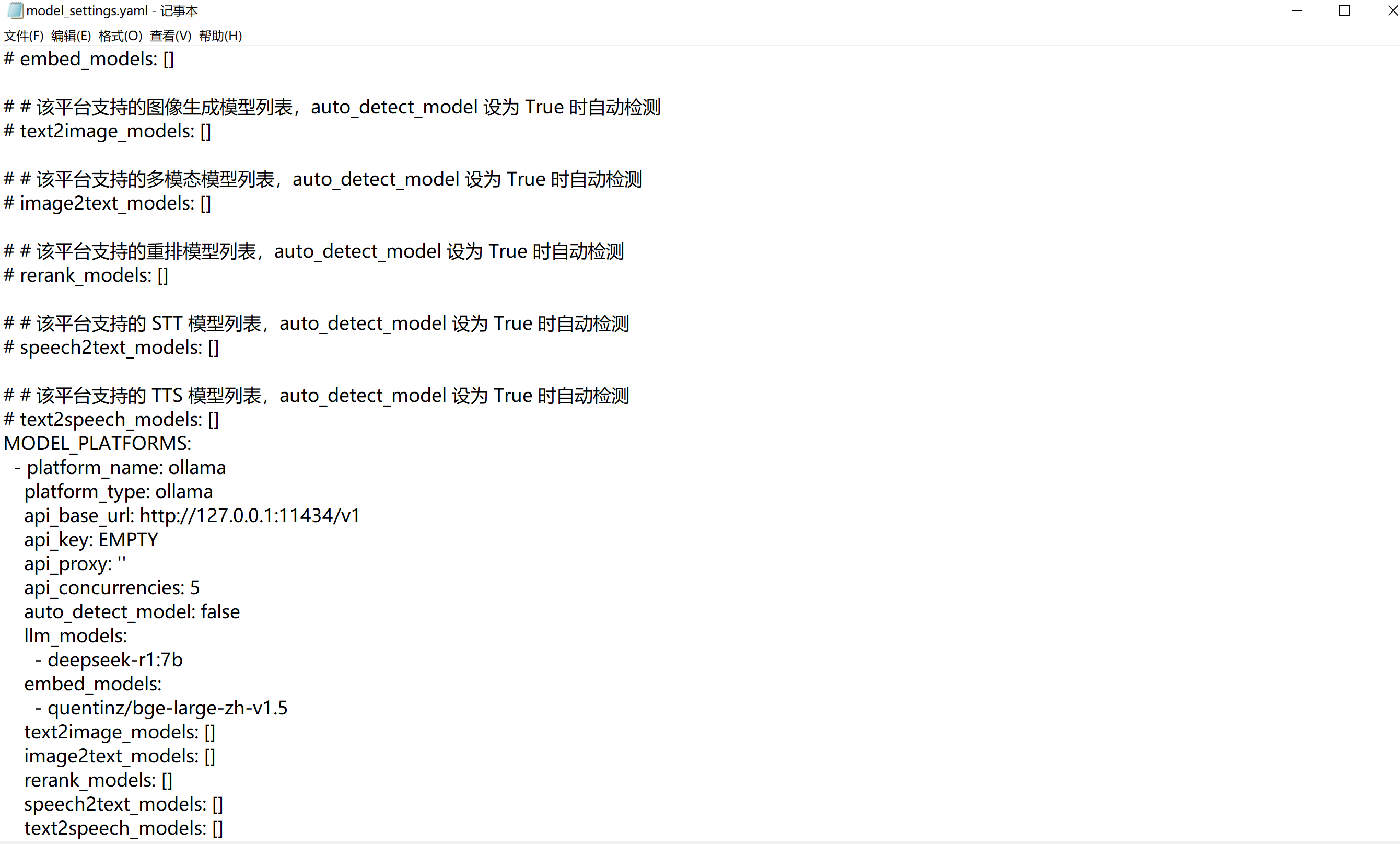

初始化成功后在项目目录中修改model_settings.yaml 文件,LLM模型设置 deepseek-r1:7b,Embedding设置 bge-large-zh-v1.5

配置 model_setting.yaml

初始化知识库

chatchat kb -r启动服务

chatchat start -a启动成功,可以进行对话或建立本地知识库对话

三、部署问题

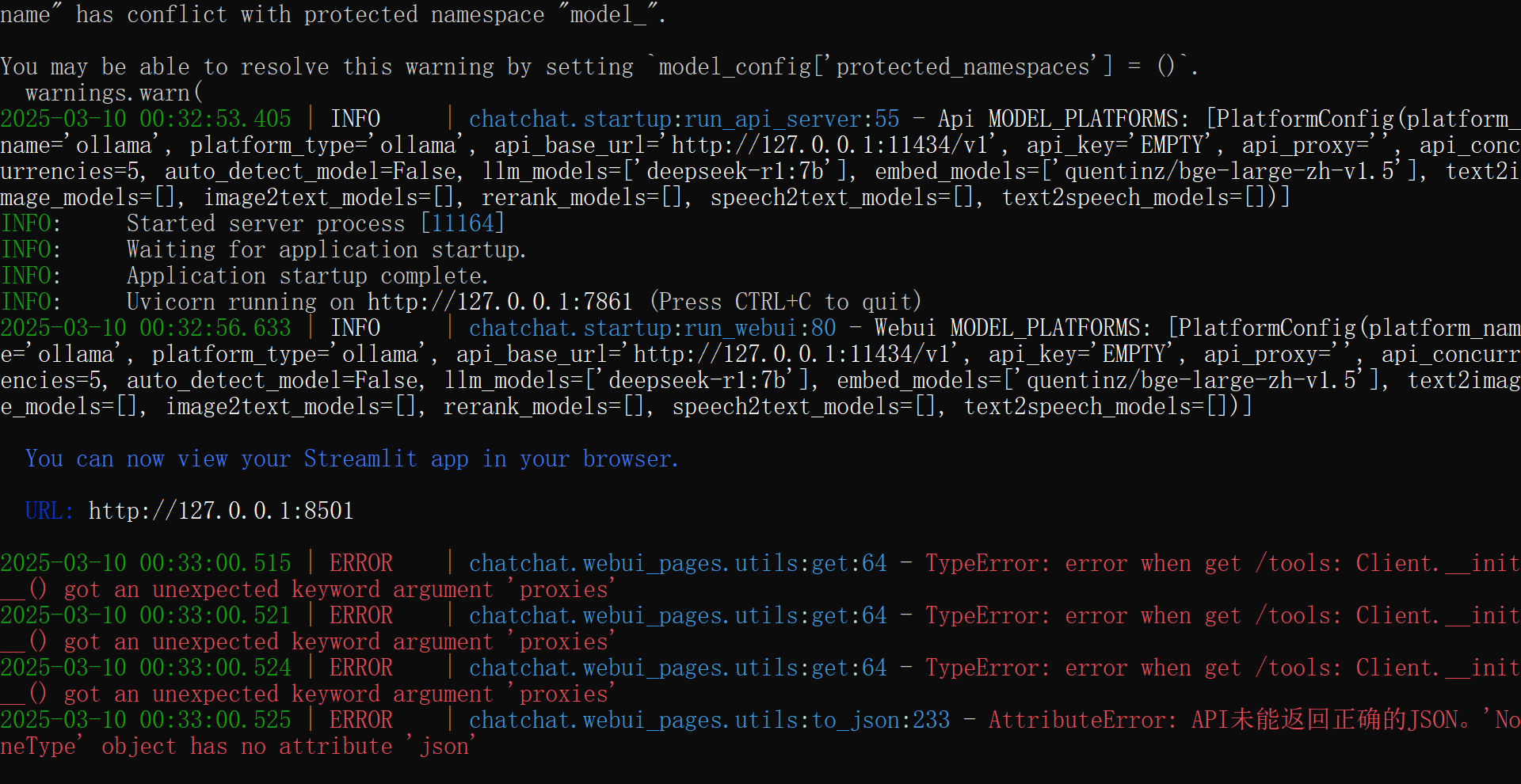

启动Langchain-Chatchat 时遇到以下问题:

解决方法:

查看httpx版本

pip list

如果 httpx==0.28.0 是不行的,需要0.27.2版本才可以,重新安装后就不会报错了

pip install --force-reinstall httpx==0.27.2知识库文档向量转换问题: Resource averaged_perceptron_tagger not found

解决方法:

https://zhuanlan.zhihu.com/p/907981580

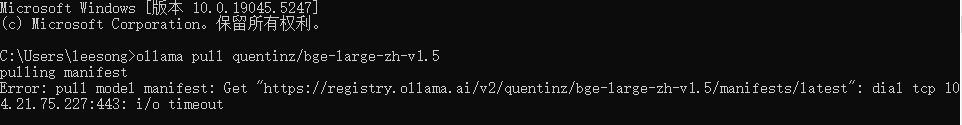

ollama pull 下载模型超时

解决方法:

- 代理的问题:尝试设置网络代理

set http_proxy=http://127.0.0.1:7890

set https_proxy=http://127.0.0.1:7890- SSL 证书问题:该错误可能与 SSL 证书问题有关,例如自签名证书。如果您处于可以信任证书的受控环境中,则可以考虑将 --insecure 标志与 ollama pull 命令一起使用,以绕过 SSL 证书验证。但是,请谨慎使用这种方法,因为它可能会使您面临安全风险。

ollama pull quentinz/bge-large-zh-v1.5 --insecurehttps://github.com/ollama/ollama/issues/3504

四、参考资料

https://blog.csdn.net/ANONYMOUSLAI/article/details/145611994